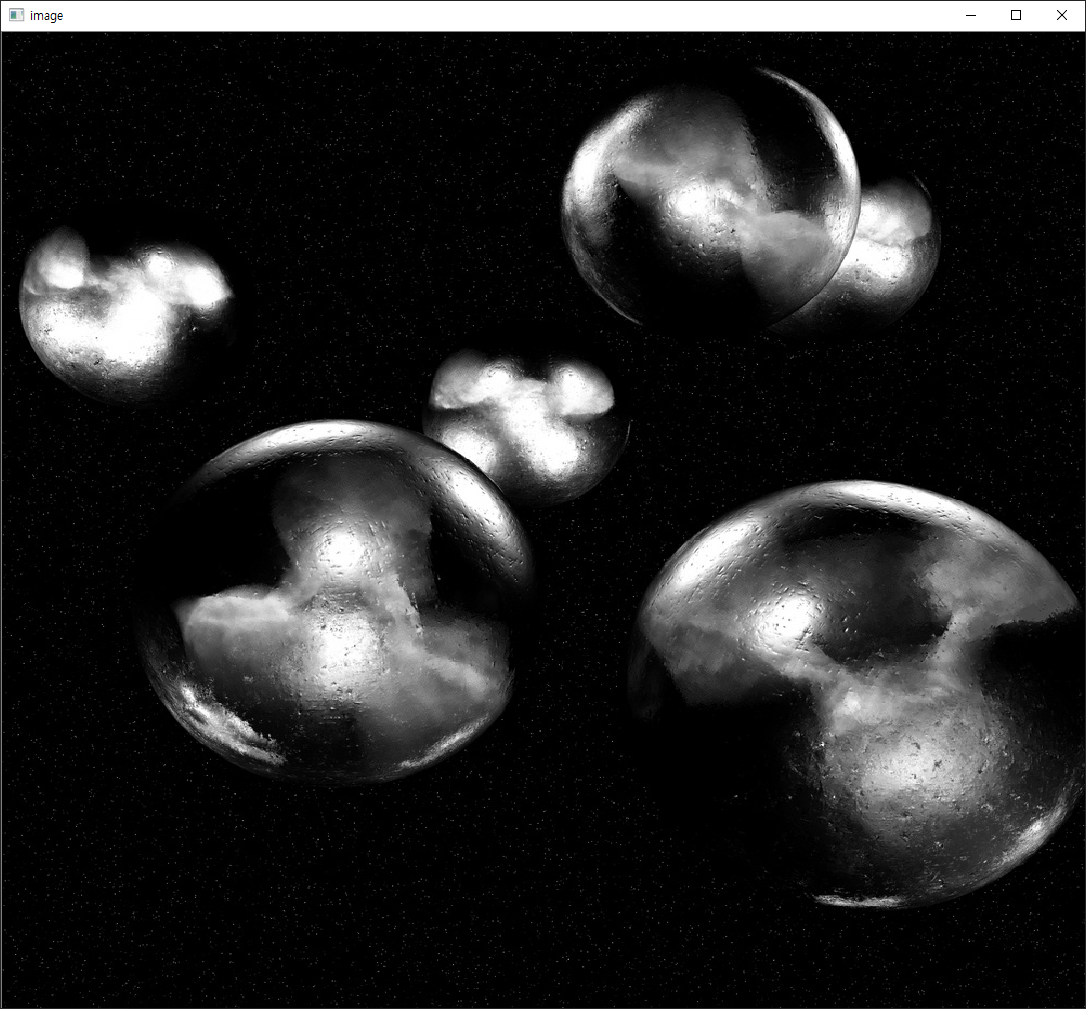

원문은 https://opencv-python-tutroals.readthedocs.io/en/latest/py_tutorials/py_gui/py_video_display/py_video_display.html 입니다. OpenCV에는 카메라를 통해서도 이미지를 받을 수 있습니다. 아래의 코드는 컴퓨터에 연결된 카메라를 통해 영상을 받아 표시하는 코드입니다.

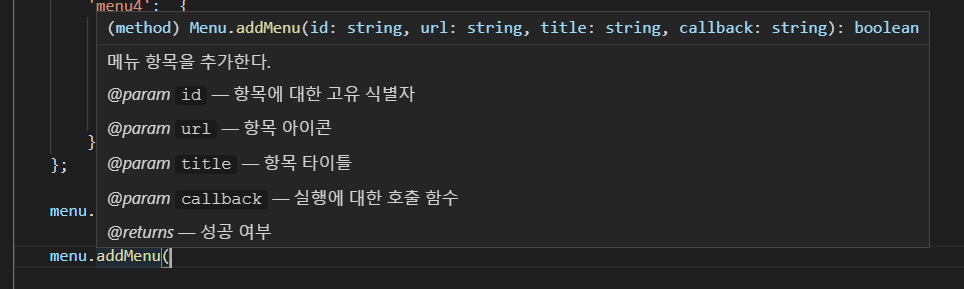

import numpy as np

import cv2

cap = cv2.VideoCapture(0)

print(cap.get(3), cap.get(4))

ret = cap.set(3,320)

ret = cap.set(4,240)

while(True):

ret, frame = cap.read()

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

cv2.imshow('frame', gray)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

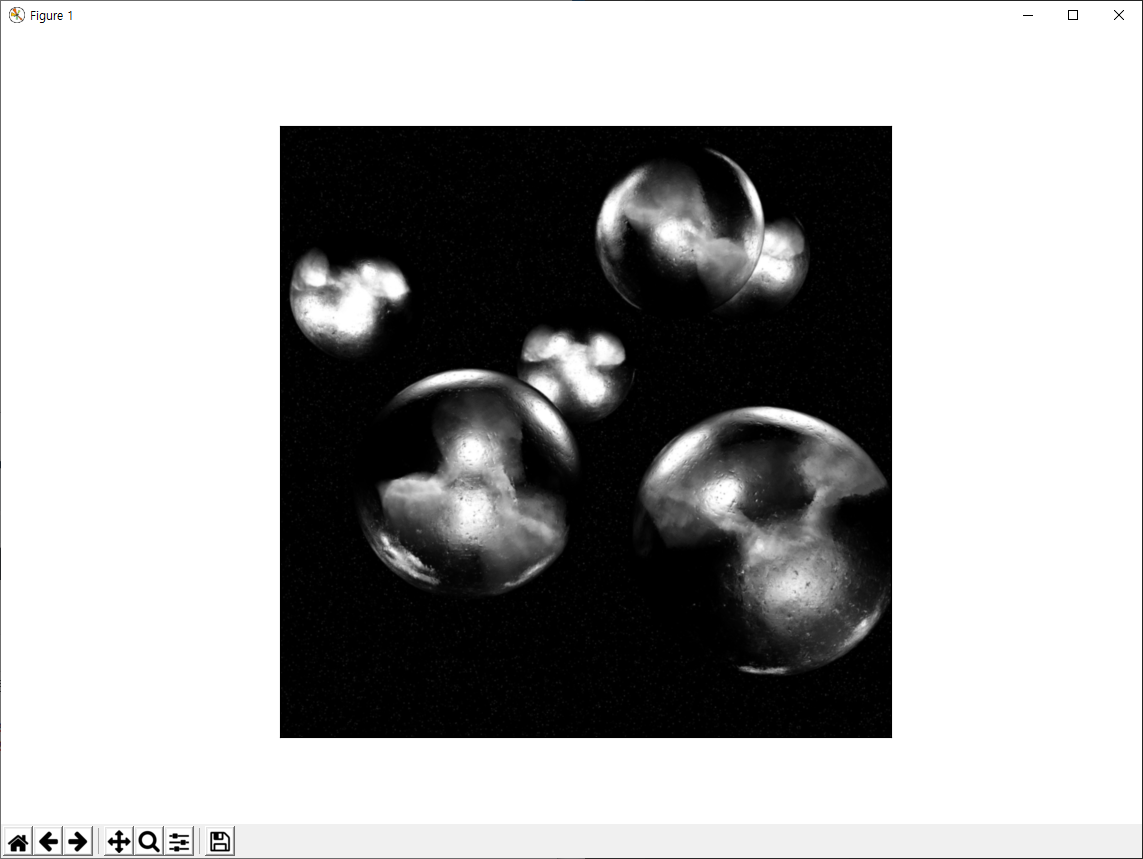

4번 코드에서 첫번째(0) 카메라를 VideoCapture 타입의 객체로 얻어옵니다. 6번은 이 카메라의 영상에 대한 가로, 세로에 대한 픽셀 길이를 출력합니다. 필자의 경우 640 480이 출력되었습니다. 8,9번 코드를 통해 가로와 세로의 크기를 각각 320×240으로 변경합니다. q 키를 누를때까지 11번의 반복문이 무한 반복됩니다. 12번에서 카메라로부터 현재의 영상 하나를 읽어오고, 14번에서 이 영상을 Gray로 변환합니다. 16번에서 이 Gray 영상을 Window에 표시합니다. q 키를 눌러 Window를 닫게 되면 프로그램이 종료되는데, 이때 사용한 카메라에 대한 리소스 해제에 대한 코드가 20번입니다.

카메라로부터 영상을 표시할 수도 있지만, 이를 파일로 기록할 수도 있습니다. 이래의 코드처럼요.

import numpy as np

import cv2

cap = cv2.VideoCapture(0)

fourcc = cv2.VideoWriter_fourcc(*'XVID')

out = cv2.VideoWriter('d:/output.mp4', fourcc, 20.0, (640,480))

while(cap.isOpened()):

ret, frame = cap.read()

if ret == True:

frame = cv2.flip(frame, 0)

out.write(frame)

cv2.imshow('frame', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

else:

break

cap.release()

out.release()

cv2.destroyAllWindows()

7번의 코드에서 기록할 동영상 파일명과 프레임률(20), 영상의 크기(640, 480)을 지정합니다. 파일명의 확장자는 mp4나 avi 등이 가능한데, 확장자에 따라 만들어지는 영상의 포멧이 결정됩니다. 실제 영상의 저장은 13번 코드입니다. 테스트로 12번 코드에서 영상을 뒤집어 기록하도록 하였습니다. q 키를 눌러 영상을 기록하는 반복문이 종료되면 비디오 객체를 해제해야 하는데 해당 코드가 바로 21, 22번입니다.

카메라가 아닌 동영상 파일로부터도 영상을 얻어 표시할 수 있는데, 해당 코드는 아래와 같습니다.

import numpy as np

import cv2

cap = cv2.VideoCapture('./data/vtest.avi')

while(cap.isOpened()):

ret, frame = cap.read()

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

cv2.imshow('frame',gray)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

카메라를 통한 영상 표시에 대한 코드와 모두 동일한데, 차이점은 단지 4번의 VideoCapture 함수의 인자가 카메라 인덱스가 아닌 파일명이라는 점입니다.